ITALIA - LIVE TURING

L'intelligenza artificiale nella musicadi Daniele Cassaghi e Giulio Zangrandi

«God save our gracious king. Long live our noble king. God save the king». Chissà se Alan Turing aveva canticchiato tra sé e sé queste parole quando fece uscire per la prima volta le note dell’inno nazionale britannico dalle casse di un computer. Era il 1951 e ai giornalisti convocati in quel pomeriggio di Manchester dal padre dell’informatica moderna per assistere alla dimostrazione parve straordinario anche solo poter riprodurre una melodia attraverso stringhe di codici. Oggi l’intelligenza artificiale è in grado di comporre, tanto che anche artisti del calibro di David Bowie o Björk hanno rivelato di essersene serviti.

Nel 2016 Sony Music ha lanciato The Flow Machine, un software capace di creare musica sulla base dell’apprendimento di repertori quali quello dei Beatles o di Bach. Nei suoi studi di Abbey Road a Londra, Universal Music fa lavorare senza sosta Ai Music ed Humtap, due piattaforme in grado di affiancare i compositori nelle sale di registrazione fornendo loro un set di dati sui quali costruire nuove sonorità. Appena due anni fa l’etichetta discografica Warner ha siglato un accordo con Endel, società di Ai con 600 brani musicali e 20 album all’attivo, per collaborare nel campo del “context playlist”. Senza dimenticare le sperimentazioni di giganti tecnologici come Microsoft e Google, che con il progetto Magenta ha sviluppato un algoritmo in grado di produrre opere d’arte e tracce melodiche in totale autonomia.

Algoritmo

Termine di origine matematica, indica una serie di regole o indicazioni da seguire per risolvere un problema attraverso un numero finito di passi. Anche la ricetta per preparare il caffè può essere considerata un algoritmo: permette di ottenere la bevanda, una volta terminati determinati passaggi: “Svita la moka, inserisci l’acqua nella camera, inserisci il filtro, metti il caffè sul filtro etc…”

Nell’ambito dell’intelligenza artificiale, gli algoritmi sono le regole a cui la macchina si attiene per portare a termine il compito che le è stato assegnato. In altri termini, sono le indicazioni che segue per decidere il suo output a partire dal suo dataset (vedi “dataset”). Questi possono essere impostati dall’essere umano, ma le Ia più evolute sono in grado di creare da sé i propri algoritmi, risultando in alcuni casi incomprensibili agli stessi studiosi. Per i grandi colossi del digitale come Google o Facebook, gli algoritmi per trattare i dati sono il vero valore industriale delle piattaforme e per questo la loro natura rimane segreta.

Dataset

Il dataset è l’insieme di dati a partire da cui lavora l’intelligenza artificiale. In gergo si dice che questi dati sono “dati in pasto” alla macchina. Tuttavia lo stesso insieme di dati può essere lavorato in modo differente dalla macchina a seconda delle diverse regole che deve seguire (vedi “Algoritmo”), determinate dal suo obiettivo. Per esempio lo stesso dato che Gianluca è residente a Milano può essere trattato in modo differente se la macchina deve selezionare tutti gli abitanti di Milano o scartare gli abitanti di Milano.

La qualità del dataset deriva dalla completezza dei dati, dal loro aggiornamento, dal fatto che non siano duplicati. Se i dati non sono ad accesso libero, “open source”, può essere economicamente gravoso ottenerli per darli in pasto all’intelligenza artificiale. Lo sa bene chi acquista le licenze per riprodurre le canzoni per conto delle piattaforme streaming.

Rete Neurale

La Rete Neurale è una rete informatica che cerca di replicare il funzionamento del cervello umano imitando le connessioni dei gruppi di neuroni. Non tutte le intelligenze artificiali sono basate su Reti Neurali, ma le più potenti lo sono. Le Reti Neurali hanno applicazioni in vasti campi: dalla Cyber Security all’anonimizzazione dei dati.

Fase Generativa e di Apprendimento

La vita di un’Ia in grado di apprendere (vedi “Machine learning” e “Apprendimento”) è scandita da due fasi.

Con “fase generativa” si intende il momento di progettazione dell’intelligenza artificiale, la preparazione del dataset e l’analisi dei rischi dei comportamenti dell’Ia.

La “fase di apprendimento” è quando l’intelligenza artificiale è operativa e inizia ad apprendere determinati fattori. Se fatta bene, impara sempre di più e crea un tesoro di nuove informazioni su cui è in grado di operare. Come un bambino che cresce.

Apprendimento

L’apprendimento dell’Ia funziona grossomodo come quello di un essere umano: o ricevendo informazioni dall’esterno, o seguendo regole che lo orientano, o a causa dell’intervento dell’essere umano che aggiunge o toglie informazioni.

Un computer può aumentare la sua “conoscenza” semplicemente grazie agli umani che immagazzinano dati nuovi ogni giorno. Il livello successivo è il machine learning (vedi “machine learning”) grazie a cui la macchina può generare nuove informazioni da utilizzare in futuro. Questo è possibile grazie all’enorme potenza di calcolo che le permette di correlare i dati che ha nel dataset in modo più rapido e di considerare dati che agli umani sembrano irrilevanti. Il grande vantaggio del computer è quello di immagazzinare dati in pochi secondi, anziché in una vita. Un musicista ci impiega anni a imparare tutta la discografia dei Beatles. L’intelligenza artificiale, no.

L’apprendimento può essere libero o supervisionato. Nel primo caso dopo l’impostazione iniziale, la macchina prosegue la sua elaborazione in modo indipendente. Nel secondo l’essere umano interviene per correggere alcuni risultati, come il maestro di musica che segue l’allievo.

Machine e Deep Learning

L’intelligenza artificiale si divide in due grandi famiglie:

La prima dipende del tutto dai dati e dalle funzioni immesse dall’essere umano.

Le Ia della seconda famiglia, invece, sono in grado di imparare da sola nuovi dati da utilizzare. Il termine “machine learning” indica che la macchina funziona in questo secondo modo. In base ai dati immessi e alle operazioni su quei dati si fa una memoria e una conoscenza. Un esempio sono i videogiochi come Candy Crash, che sono in grado di apprendere gli errori dei giocatori e suggerisce dei pezzi più facili.

Il termine “deep learning” indica il tipo di apprendimento “più profondo” tra quelli che configurano il machine learning. Grazie al deep learning una macchina è in grado di generare nuovi contenuti come un essere umano. Il deep learning è utilizzato soprattutto sui dispositivi che fanno traduzione linguistica, dove è necessario imparare moltissime cose riguardo a lessico, contesto e registro, in modo da adattarsi di volta in volta alla situazione e proporre il contenuto giusto di cui l’essere umano ha bisogno in quel momento.

Un trend in forte crescita, insomma, da cui neppure l’Italia è esclusa. Anche nel nostro Paese l’intelligenza artificiale sta infatti muovendo passi da gigante. Secondo le ultime stime di Assintel Report, l’osservatorio permanente sul mercato digitale realizzato dall’associazione nazionale delle imprese Ict di Confcommercio e curato da Idc, il mercato italiano dell’Ai vale già 860 milioni di euro e promette di crescere fino a 1,4 miliardi entro il 2023. In questo quadro, a trovare un terreno particolarmente fertile è proprio l’applicazione dell’Ia alla musica. Software per improvvisare in modo sempre nuovo. Computer che compongono canzoni seguendo regole autogenerate. Programmi per analizzare un violino prima ancora che esista. Ma anche creatori di melodie per lenire il dolore e perfino insegnanti di musica digitali. Sono questi i progetti in cui è possibile imbattersi esplorando i laboratori delle nostre università e delle nostre startup. Ma se nel fenomeno qualcuno intravede un’opportunità, per altri vi si cela una minaccia. Tanto che, anche da noi, la domanda di fondo resta sempre la stessa: potrà l’intelligenza artificiale sostituire la creatività umana?

1. Stradivari Digitali

1.1 Il Laboratorio

Entrando da un porticina sul lato del Museo del Violino di Cremona si arriva al piccolo Laboratorio di Acustica Musicale. Qui Sebastian Gonzalez e Davide Salvi portano avanti le loro ricerche per il Politecnico di Milano. «Grazie all’intelligenza artificiale siamo stati in grado di associare la forma delle tavole armoniche dei violini al tipo di vibrazioni che essa genera», così Salvi sintetizza il contenuto di A Data Driven Approach to Violin-Making, il paper scritto insieme a Gonzalez e agli altri membri del gruppo di ricerca e pubblicato su Nature: Scientific Reports. In sostanza, il software permette di prevedere il modo in cui una certa tavola armonica del suo dataset vibrerà a seguito di una stimolazione. Né la tavola, né la stimolazione esistono in concreto: l’Ia lavora su dei modelli digitali ricavati a partire dallo studio di un singolo violino.

Ma soprattutto il programma permette di fare il contrario. «Si può invertire la pratica con cui si costruiscono gli strumenti», spiega ancora Salvi: «Anziché copiare la geometria della tavola per capire in un secondo momento come suona, si può cercare di ottimizzarne la forma, una volta che si è scelto come deve vibrare». Per il futuro, l’obiettivo è di completare la ricerca, analizzando come le altre parti del violino incidono sul suono finale e nulla vieta di farlo per altri strumenti musicali. Ma si dovrà attendere: «Una cosa molto difficile da elaborare è l’interazione tra il legno e l’aria, che poi è quello che davvero produce il suono», aggiunge Gonzalez: «È probabile che i nostri computer impieghino il doppio del tempo per farlo rispetto al lavoro sulla sola tavola».

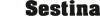

Modelli geometrici

Il disegno storico, della bottega di Enrico Ceruti, da cui ha tratto ispirazione la parametrizzazione della forma esterna della tavola (a) e l’effettiva modellazione geometrica usata (b)

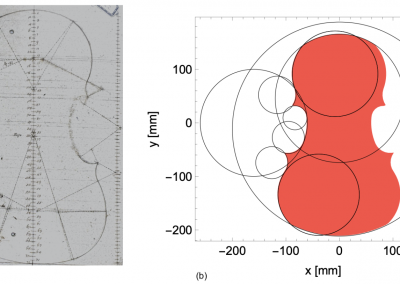

Profili di Violino

Violino a sinistra: profilo di un violino storico © 2008 Stoel, Borman. Sulla destra tre esempi di tavole del dataset.

1.2 La Tradizione

Sapere come si comporta un violino prima ancora che esista può essere attraente per gli scienziati interessati alla fisica acustica: permette di velocizzare il lavoro. Ma la vera sfida all’Ia di Salvi e Gonzalez si avrà quando si cercherà di costruire la prima tavola armonica progettata con il loro software. «Lavorare con il legno è una scommessa mai vinta», sorride Lorenzo Frignani, il presidente dell’Associazione Liutai Italiani Professionisti. «Il legno non ha caratteristiche costanti: se cambia un gradiente di umidità, cambiano le proprietà del materiale. Non c’è una macchina che mi dice: “hey, oggi è il giorno giusto ma attento che domani cambia la luna”». Insomma,bcostruire nel concreto uno strumento richiede una certa esperienza, necessaria ad adattare il lavoro alle circostanze del momento: «Il legno va interpretato, si modifica costantemente. Uno Stradivari costruito 300 anni fa ha ora caratteristiche differenti rispetto a quando è stato fatto», conclude Frignani. E su questo sembrano essere d’accordo anche i due ricercatori, che in modo esplicito ritengono il loro software un supporto e non un sostituto dell’artigiano. Senza contare il valore di chi lo suona: uno stesso violino nelle mani di dieci artisti può suonare in modo sempre diverso. Un parametro questo che ancora non è stato preso in considerazione dal machine learning.

La liuteria è un settore che – per dirla insieme a Frignani – «calza le scarpe della tradizione». Ma non è un’arte che rifiuta del tutto le novità. La tecnologia ha ampi usi in fase di restauro. I computer possono dare una mano nell’individuazione delle problematiche dei pezzi da rimettere a nuovo. Ma non solo: le innovazioni possono aiutare a proteggere il lavoro degli artigiani stessi. «Con alcuni esperti e una compagnia assicurativa stiamo lavorando a una banca dati per censire e rendere riconoscibile a chiunque online se uno strumento l’ho fatto io», rivela Frignani. Lo scopo è quello di capire se si tratta di un falso: un problema rilevante dato che i violini di liuteria arrivano a costare decine di migliaia di euro. Ad applicazioni di questo tipo se ne affiancano altre come i chip di rilevamento: inseriti all’interno dello strumento, permettono di rintracciarlo in caso di furto o smarrimento tramite Gps, cioè tramite un’intelligenza artificiale.

1.3 Il “metastrumento”

La tradizione non è invece nei pensieri di Bruno Zamborlin. Partito per Londra per fare un dottorato in intelligenza artificiale, nel Regno Unito ha capito che poteva creare un “metastrumento”, cioè un dispositivo per trasformare qualsiasi cosa in uno strumento a percussione melodica. Grazie a un sensore, il suo Mogees è in grado di imparare tutti i modi diversi con cui vibrano le superfici degli oggetti e associare loro un suono. Ed ecco che tavoli e sedie si trasformano in strumenti musicali. Brian Eno, Jean-Michel Jarre e il duo Plaid sono tre dei nomi che hanno voluto includere Mogees nei loro live.

«Tutto è nato per una sorta di invidia nei confronti della musica suonata dal vivo», dice Zamborlin ridendo: «Volevo quindi aggiungere alla musica elettronica quello che le mancava: l’improvvisazione e la possibilità di vedere i musicisti impugnare gli strumenti». Rispetto a questa però, la musica di Mogees mantiene una certa imprevedibilità dovuta alla composizione sempre diversa dell’ambiente in cui è inserito e dai movimenti delle persone che interagiscono con gli oggetti. E quando dopo alcuni concerti il pubblico ha potuto sempre far suonare l’arredamento, la reazione era di grande sorpresa.

Oggi Mogees non è più in commercio. La startup con cui è nata è confluita in un’altra società controllata da Zamborlin, Hypersurfaces, il cui prodotto è l’evoluzione del primo: un sensore in grado di associare le vibrazioni degli oggetti a funzioni di controllo, anziché a suoni. In pratica trasforma gli oggetti di uso comune in telecomandi che possono essere utilizzati per i più svariati scopi: accendere o spegnere le luci, alzare il volume dello stereo etc… Nonostante ciò, Zamborlin è ancora molto legato a Mogees, che usa spesso per integrare le opere di altri artisti: sculture sonore, come quella gigantesca in un’oasi nel deserto del Saudi, oppure spazi di architettura urbana.

2. Bach Artificiali

La creazione di strumenti musicali non è però l’uso più noto dell’intelligenza artificiale nella musica. Il 21 marzo 2019, per celebrare l’anniversario di nascita di Johann Sebastian Bach, Google ha realizzato il suo primo doodle basato sul machine learning. Cliccando sul sito, gli utenti potevano comporre una melodia, che veniva arrangiata in stile bachiano a partire dalle 306 corali che costituivano il database. Ma qual è il vantaggio di copiare gli artisti in questo modo? «Un grande editore ci ha chiesto di ‘clonare’ un suo compositore con la nostra Ia», racconta Simone Geravini fondatore e amministratore delegato di Veos Digital, «l’analisi effettuata dalla nostra Ia ha permesso al musicista stesso di essere più consapevole delle sue caratteristiche distintive nel fare musica e in più la macchina può suggerire dei modi per completare le proprie opere quando si ha un blocco creativo».

2.1 L’improvvisatore senza memoria

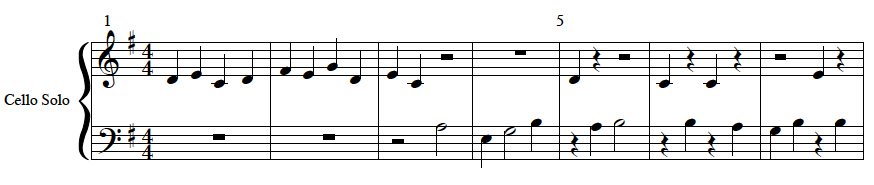

Ma in Italia c’è anche chi sta lavorando a qualcosa di diverso, un sorta di assistente musicale in grado di accompagnare gli artisti direttamente nelle performance dal vivo. È l’idea alla base di A-MInt, algoritmo capace di interiorizzare in tempo reale lo stile d’improvvisazione del musicista per poi creare, a partire da esso, un numero di tracce potenzialmente infinito con cui affiancarlo durante l’esecuzione.

Il progetto nasce dalla visione di Alex Braga, conduttore radiofonico e televisivo, produttore discografico ed autore ma soprattutto pioniere della cosiddetta “augmented music”, una tecnica innovativa che sfrutta la tecnologia come supporto per permettere all’artista di suonare un numero potenzialmente infinito di strumenti. È l’inizio del 2017 quando il 46enne di Novara decide di mettere la sua filosofia a servizio di una causa ben precisa: superare lo stereotipo della macchina come sostituto o rivale dell’uomo. A-MInt vuol dire proprio questo: «Artificial. Music. Intelligence». Un’esplicita dichiarazione dei tre ingredienti che la “creatura” di Braga intende mixare nei suoi concerti. A stendere nero su bianco la ricetta che li tiene uniti, due professori dell’Università Roma3 già avvezzi all’applicazione dell’Ia in altri campi dell’ingegneria elettronica: Antonio Laudani e Francesco Riganti Fulginei. Tra i vari accademici interpellati per dare il via ai lavori, loro sono stati i primi a rispondere e oggi figurano tra i co-fondatori della startup creata per portare avanti l’iniziativa.

A-MInt è un’intelligenza artificiale sui generis perché può apprendere live ascoltando l’artista senza bisogno di alcuna conoscenza passata e senza essersi esercitata su un database di melodie. Il musicista sale sul palco e inizia a suonare il suo strumento; le note prodotte vengono comunicate all’Ia sotto forma di metadati e questa, partendo da zero, avvia un rapido ciclo di addestramento che le permette nel giro di pochi secondi di restituire il suono di un violino, di una chitarra, di un basso o di qualsiasi altro strumento si sia scelto di voler utilizzare come accompagnamento.

Lo scopo del progetto è in effetti proprio quello di generare musica costantemente nuova: «Non ci interessava un’Ai che copiasse l’artista, ma che lo accompagnasse durante la composizione», spiegano Laudani e Riganti Fulginei. Da qui la scelta di programmare il computer come se fosse un musicista dotato di un buon orecchio ma di scarsa memoria: «Così, anche se l’esecutore umano dovesse ripetere la stessa melodia, A-MInt suonerà in modo diverso rendendo unica la performance».

Tutto questo è possibile perché, invece di utilizzare algoritmi di machine learning o deep learning, il software funziona in base a un algoritmo di apprendimento implementato a basso livello. «Qui non si va a pescare dall’esistente ma l’Ia ragiona a brevissimo termine: interagisce con quello che il musicista sta suonando sul momento, non sa nulla di quello che c’era prima e dimentica immediatamente quello che ha fatto. Così se da un brano all’altro cambia il registro, la macchina si riaddestra di conseguenza». In pratica, chiariscono i due ricercatori, ogni performance di A-MInt è come una nascita: «Quando l’accendiamo, è come se nascesse un bambino che non sa suonare, che non conosce le regole armoniche, che padroneggia la composizione ma risponde solo in funzione di ciò che sente».

A fare ancora più chiarezza ci pensa Braga, che in questi quattro anni ha portato A-MInt in giro per il mondo rendendolo protagonista dei suoi concerti: «Immaginate di poter suonare con un clone di voi stessi, un gemello più stravagante che, dopo essersi “scaldato”, inizia a suggerirvi percorsi sonori ai quali non avreste mai pensato, ma sempre assolutamente coerenti con il vostro stile». Un meccanismo replicabile all’infinito, data la possibilità di impostare il dispositivo affinché riproduca qualsiasi strumento in aggiunta a quello maneggiato dal suo “partner umano”.

2.2 La musica per le macchine

I creatori di A-Mint non sono i soli a trovare noiosa l’idea di sviluppare l’ennesimo software che completi l’incompiuta di Johann Sebastian Bach scimmiottando lo stile dell’autore. «Volevo creare un’intelligenza artificiale che decidesse da sola cosa comporre e come: questo è l’obiettivo finale di un’Ia generativa», rivela Francesco Bardozzo, ricercatore dell’Università di Salerno, noto nel mondo del mondo musicale con lo pseudonimo di Oberlunar. Insomma, va bene inserire dentro Obernaut (così si chiama il programma che ha ideato) le composizioni bachiane, ma perché non far sì che la rete “intuisca” da sola il procedimento da seguire per comporre? In questo caso non ci sarebbe un essere umano che le indica la ricetta da seguire per scrivere i brani à la Bach. Dovrebbe essere lei stessa a cercare di capire da sola quali fossero le regole che animavano il compositore settecentesco nella creazione delle sue opere. E non è detto che le conclusioni da parte dell’Ia siano le stesse del maestro tedesco. In gergo questo si chiama “apprendimento non supervisionato”. L’album Destructured Bach è nato così.

All’ascolto le melodie di questo Ep appaiono distopiche. Alle volte sembra che la conclusione non arrivi mai per via delle continue scelte da parte di una macchina in grado di elaborare moltissime possibilità per proseguire una determinata traccia. A noi che siamo abituati alla musica degli umani sembrano bizzarre, ma Obernaut non crea seguendo dei procedimenti che assicurano la godibilità per l’orecchio umano. Scrive seguendo ricette tutte sue, componendo “una musica per le macchine”, o forse per lei stessa. Ne è consapevole lo stesso Bardozzo: «L’album è stranissimo. Dal punto di vista artistico però ha senso: possiamo ascoltare della musica che altrimenti non avremmo potuto ascoltare».

L’album ha ricevuto feedback molto positivi da parte di esperti musicali, tra cui il jazzista Antonio Gallucci. Con il suo aiuto, Obernaut promette di esplorare possibilità musicali ulteriori. Quando un jazzista improvvisa segue dei criteri che limitano la scelta delle note da suonare. Non solo, bisogna anche rispettare il tempo del brano. Regole che sono il frutto della pratica umana e sono state riviste quando Gallucci ha improvvisato seguendo le creazioni di Obernaut. Questo approccio rompe sia con il modo tradizionale di intendere il rapporto tra artista e software, sia con il modo normale di intendere la jam session tra due umani, dove chi improvvisa reagisce a chi accompagna e viceversa. Le applicazioni come A-MInt rispondono al modo di suonare dell’artista e adattano le proprie decisioni alla fantasia dell’essere umano. «Sono io che suono A-MInt» chiarisce Braga. Obernaut “suonava con” Gallucci, imponendo a lui regole a cui il jazzista si è adattato per il suo assolo. In questo esperimento la macchina non ascoltava, non reagiva a quello che il sassofonista faceva. Il vantaggio per l’uomo è quello di avere scoperto nuovi schemi e idee musicali da trasferire in altri contesti: «L’improvvisatore non dovrebbe reiterare i propri pattern melodici, ma non è sempre facile», spiega Gallucci dopo la jam: «Questo è un tool per spingersi fuori dalla zona di confort ed essere “costretti” a trovare soluzioni melodiche e armoniche mai esplorate prima». L’album Sax Droids, che raccoglie i risultati dell’interazione tra Gallucci e il programma, è già in cantiere.

Per Bardozzo sembra essere molto lontano il 2020, quando il suo primo lavoro Adhal è comparso sulla pagina spotify del suo alter-ego Oberlunar. «Sono passati solo un paio d’anni. In quel momento utilizzavo reti neurali molto molto semplici che davano pattern musicali senza senso. Sembravano casuali», dice Bardozzo: «poi sono intervenuto io a modificarli per creare un disco, ma è stato un primo tentativo di introdurre la “musica neurale” nell’interazione tra uomo e macchina». Non sarà così per Sax Droids, dove non ci sarà nessuna correzione umana: tutto ciò che è uscito dal Sax di Gallucci e dalla macchina sarà proposto senza alterazioni.

3. Oltre l’arte

3.1 Il sollievo dal dolore

Per quanto riguarda i contenuti prodotti da intelligenze artificiali, Spotify non distribuisce solo quelli di chi è intento a esplorare nuovi ambiti artistici. C’è anche chi compone a scopo terapeutico. Digitando “Melomics Health” sulla barra di ricerca ci si imbatte in un logo suggestivo: una nota musicale che racchiude un cervello stilizzato. Scorrendo tra gli album, si leggono nomi come For Pain Relief Op. 1 e For Relaxation Op. 2. I contenuti delle tracce sono monodie, linee melodiche a una sola voce, senza accompagnamento. «Il nostro algoritmo produce musica molto semplice, adatta per la musicoterapia, quel particolare tipo di psicoterapia che cerca di ottenere un influsso benefico sui pazienti servendosi di vari elementi musicali», rivela Alfredo Raglio, dell’Istituto di ricerca Medico-Scientifica Antonio Maugeri di Pavia.

Sviluppata insieme a Francisco Vico dell’università di Malaga, l’intelligenza artificiale Melomics Health compone tracce musicali da utilizzare in ambito clinico. E Raglio studia gli effetti della somministrazione di questi brani a chi soffre di ansia, stress, dolore cronico o acuto (soprattutto a seguito di casi di fibromialgia). Per queste persone ascoltare le tracce di Melomics serve a tre scopi principali: rilassarsi, attivarsi o distrarsi. La ricerca è lontana dall’essere conclusa, ma sembra che qualche dato positivo stia iniziando ad emergere. Anche se, precisa Raglio: «La musicoterapia non potrà mai avere gli stessi effetti dei farmaci, serve piuttosto come approccio complementare».

L’approccio dietro Melomics è l’opposto di quello di Obernaut o A-Mint. «Normalmente la creatività data da un’artista è un plusvalore. Ma in un contesto clinico la sua assenza rende gli stimoli estremamente simili fra loro e permette quindi di confrontarli», riflette Raglio. Un vantaggio per i ricercatori che raccolgono dati. Inoltre, l’essenzialità della composizione permette ai terapeuti di adattare in modo più efficace le tracce alle esigenze specifiche dei pazienti. Cosa molto più difficile se i brani contenessero parametri più complessi e articolati come le sequenze armoniche. Insomma, alle volte la mancanza di originalità tipica delle intelligenze artificiali supervisionate può essere una risorsa, così come la generazione di brani “artificiali”, che non sono quindi il prodotto di una specifica influenza culturale. Questo permette di sottoporre a musicoterapia individui di estrazioni diverse. E poi c’è il fattore tempo: un compositore impiegherebbe mesi per scrivere la stessa quantità di tracce create da Melomics. Lo sanno bene i ricercatori Luca Manzoni (Università di Trieste) e Mauro Castelli (Nuova Università di Lisbona) che insieme a Raglio stanno ultimando l’ultima versione del programma.

Traccia sperimentale

3.2 Il mentore informatico

Curare i pazienti con le melodie prodotte da una macchina non è però l’unica esperienza di applicazione dell’Ai fuori dagli schemi. C’è anche chi, ad esempio, ha scelto di utilizzare gli algoritmi per creare un “canzoniere musicale”: si tratta di Simone Geravini, informatico con la musica nel sangue che nel 2016 ha lanciato insieme ad alcuni soci la startup monzese Nami Lab.

Un cervello umano suddiviso in due emisferi, di cui uno attraversato da circuiti elettrici: basta uno sguardo al logo che campeggia negli uffici di Nami, in pieno centro a Milano, per intuire la filosofia alla base della società, oggi attiva sotto il nome di Veos Digital e specializzata in artificial intelligence per aziende energetiche, finanziarie, della sanità: «Qui applichiamo l’intelligenza artificiale ai contesti creativi», spiega Geravini. Che per quanto riguarda il settore musicale, riassume così il frutto del lavoro di questi 5 anni: «Abbiamo insegnato a un computer a riconoscere gli accordi come se fosse un musicista con un’accuratezza dell’85%» .

In pratica, al di là della richiesta che gli è arrivata di ‘clonare’ un compositore per aiutarlo nella creazione, lo sforzo principale di Geravini e Co. è andato nel senso opposto: non creare melodie a partire da note o accordi ma scomporre la musica nei suoi elementi essenziali per renderla fruibile da quante più persone possibili. Ed è proprio da questo sforzo che ha avuto origine Yalp, una web app con cui è possibile trascrivere gli accordi musicali partendo da un semplice file audio. A descrivere come funziona è lo stesso Geravini: «In Yalp utilizziamo l’intelligenza artificiale per trascrivere l’armonia delle canzoni. L’intero procedimento si articola in due step: in un primo momento, il software estrae gli accordi, cioè la sequenza armonica, e la velocità metronomica con cui il brano si sviluppa; poi un’ulteriore serie di algoritmi si preoccupa di separare le tracce». In pratica, prosegue l’imprenditore: «È come avere a disposizione un mixer virtuale che permette di separare le sorgenti e quindi i singoli strumenti». Una funzionalità pensata per andare incontro alle esigenze di chi vuole iniziare a fare musica. «Sono un musicista in erba e voglio imparare a suonare la mia canzone preferita. Vado sul sito di Yalp, cerco il file audio corrispondente e in dieci secondi potrò visionare gli accordi necessari a prendere in mano la mia chitarra e iniziare a strimpellare», spiega Geravini.

Attualmente Yalp conta 250mila utenti da ogni parte del mondo, con una forte presenza soprattutto in Italia, Stati Uniti e Giappone. Il pubblico di riferimento è estremamente vasto: si va dai 5 ai 55 anni. E per intercettarlo è stata predisposta un’offerta freemium in cui a funzionalità di base gratuite se ne aggiungono altre “plus” pagabili tramite abbonamento mensile. «Crediamo che l’intelligenza artificiale debba affiancarsi all’uomo, per cui non intendiamo sostituire i maestri di musica. Il nostro obiettivo è anzi quello di facilitare ed aumentare anche il loro lavoro», spiega Geravini. «L’idea è semplice: grazie a Yalp una persona che prima non avrebbe neanche sognato di impugnare la chitarra si avvicinerà allo strumento in piena autonomia, quindi inizierà a cercare maggiori informazioni e la sua bravura aumenterà fino al punto di doversi rivolgere a un professionista in carne ed ossa per migliorare ulteriormente». Non solo però. «Anche un maestro alle prese con allievi in erba avrebbe convenienza a utilizzare Yalp, in questo caso come puro supporto all’attività didattica», aggiunge Geravini. Tradotto, potrebbe dire agli studenti: «Esercitatevi sulle basi a casa, così potremo sfruttare le lezioni per vedere insieme qualcosa di più avanzato che i soliti quattro accordi». Ed ecco che, conclude Geravini:«Non ci si accontenta più e si inizia a desiderare un livello superiore: scale, armonia Jazz, contrappunto».

4. La legge umana

All’inizio del 2022, Stephen L.Thaler, presidente dell’azienda produttrice di intelligenze artificiali Imagitron Lcc, attende la sentenza davanti ai giudici dell’Ufficio Copyright degli Stati Uniti d’America. Viene confermato il verdetto del 2019: a un software non può essere riconosciuta la paternità di un’opera d’arte, in questo caso un quadro intitolato A Recent Entrance to Paradise. Il motivo, spiegano gli ufficiali, è che il diritto d’autore statunitense non copre opere che non siano il frutto «dei poteri creativi della mente umana». Che si tratti di pittura o musica, anche in Europa il problema è lo stesso: come si gestisce il copyright quando di mezzo c’è un programma digitale? Per ora abbiamo un vero e proprio vuoto legislativo, che l’Ue promette di colmare entro due o tre anni: il tempo di approvare il quadro normativo sull’intelligenza artificiale. Rispetto alle bozze che circolano in questi giorni, è molto probabile che il testo subisca diverse modifiche. Tuttavia già alcuni principi emergono: l’Unione è orientata a classificare l’intelligenza artificiale per fasce di rischio. Alcune attività come quelle che implicano la manipolazione della volontà degli utenti e il “social scoring” – il sistema di punteggi per valutare la reputazione dei cittadini – saranno vietate. Stesso destino per quelle che rappresentano una chiara minaccia alla sicurezza e ai diritti delle persone. Chi vorrà investire in Ia che eseguono attività giudicate “a rischio elevato” dovrà invece attenersi a una serie di regole. Tra queste spiccano l’obbligo di tracciamento di tutte le attività della macchina e la supervisione costante dell’essere umano. Per il momento l’Europa considera ancora l’uomo come l’unica garanzia per minimizzare gli errori.

Nel frattempo in Italia artisti come Braga e Oberlunar producono già dischi grazie all’Ia con la conseguenza che le opere hanno bisogno di tutela. Anche nel nostro Paese è poco chiaro se considerare al cento percento un software alla stregua di un compositore umano, tuttavia non ci sono particolari ostacoli sul fronte della monetizzazione. «Poco importa se un jingle è prodotto da un software o da un essere umano: lo si può registrare alla Siae come un’opera nuova e sfruttare nelle modalità canoniche», spiega Lorenzo Grignani, general manager di Fuga, l’azienda di Amsterdam che si occupa di distribuire i contenuti digitali alle piattaforme e gestire le licenze. «Anche dal punto di vista della distribuzione è irrilevante», aggiunge Grignani con un esempio chiarificatore: «Se un mio cliente utilizza un software per produrre un contenuto, io posso anche non vederlo. Procedo allo stesso modo e la cosa non ha impatto sul modello di business».

Ma la questione normativa non è legata solo ai margini di guadagno. E’ soprattutto una questione di responsabilità. Cosa succede quando un’Ia lede il diritto di qualcuno, ad esempio creando un plagio? «La prima leggenda metropolitana da accantonare è quella di dare personalità giuridica a un’intelligenza artificiale», spiega Giovanni Ziccardi, professore di informatica giuridica alla statale di Milano: «Nell’orientamento europeo l’idea di responsabilità è l’idea che ci sia qualcuno a cui domandare il risarcimento di un danno, impossibile con un software». Uscire da questo schema vorrebbe dire ammettere che tra chi debba rispondere per un incidente ci siano anche oggetti inanimati. Tradotto: potremmo arrivare all’assurdo di chiedere un’indennità alla corrente in caso di guasto elettrico.

Tolta di mezzo l’idea di dichiarare un programma responsabile per quello che fa, rimangono diversi soggetti: la società che produce l’Ia, chi la modifica o personalizza per uno scopo specifico e l’utente che la può utilizzare in forma scorretta. «La soluzione più semplice dal punto di vista interpretativo è quella di distribuire la responsabilità tra questi tre», continua Ziccardi: «Si applica un po’ il principio dei giocattoli pericolosi e un po’ le regole dell’industria».

- Bozza del Regolamento Europeo per l'intelligenza artificiale

- Definizione di Ia nella bozza del Regolamento

- Intelligenze artificiali vietate

- Intelligenze artificiali ad alto rischio

- Obblighi per le intelligenze artificiali ad alto rischio

- Ia a rischio limitato o minimo

Lo scopo è di fornire un quadro comune a tutti gli Stati membri che disciplini l’uso e lo sviluppo delle Ia nel Continente. Anche le intelligenze artificiali d’importazione, cioè create fuori dai confini comunitari, dovrebbero essere soggette a queste regole.

Ci vorranno anni prima che il Regolamento entri in vigore, ma tre principi di fondo sembrano essere chiari:

- Trasparenza: le persone devono essere messe nella condizione di sapere di stare interagendo con un software. Questo può non apparire scontato quando, ad esempio, gli utenti si relazionano con un Chatbot o osservano un video “deep fake” che riproduce in modo realistico le sembianze di una persona.

- Saranno vietate tutte le Ia in contrasto con i valori fondanti dell’Unione Europea.

- Le attività considerate pericolose dovranno essere monitorate in modo costante e supervisionate dall’essere umano.

La definizione di “intelligenza artificiale” che si dà nella bozza mira ad essere neutrale sul modo con cui un’Ia è sviluppata.

L’esigenza è di avere una definizione abbastanza elastica da essere applicata a tutti i programmi, stando al passo con l’evoluzione della tecnica e del mercato.

All’interno dei confini dell’Unione non si potranno trovare software che:

- Rappresentano una chiara minaccia alla sicurezza, alla vita e a i diritti delle persone.

- Manipolano il comportamento umano, grazie alla circonvenzione del libero arbitrio degli utenti (ad esempio i giocattoli che spingono i bambini a comportamenti pericolosi grazie a un assistente vocale).

- Forniscono un sistema di “social scoring” (cioè permettono di classificare i cittadini in base a punteggi).

Non sono vietate: il loro scopo primario non è quello di costituire una minaccia e sono considerate utili.

Tuttavia, in caso di errore, possono essere pericolose.

Tra queste ci sono le Ia che possono costituire una minaccia all’integrità fisica delle persone. Esempi sono i software impiegati nelle “infrastrutture critiche”, come quelle logistiche, e nella realizzazione delle componenti di sicurezza dei prodotti.

Un secondo insieme è rappresentato da quelle che possono interferire con la realizzazione sociale degli individui. Tra queste ci sono i programmi per valutare i punteggi degli esami, l’attitudine e i curricula dei candidati per una certa posizione lavorativa o per l’ammissione a una certa università. In questa categoria ricadono anche le Ia che valutano la solvibilità creditizia di una persona per eventuali prestiti.

Un terzo gruppo di programmi potrebbero interferire con il processo democratico. Ad esempio i programmi di “law enforcement” per il riconoscimento delle prove di un crimine – che potrebbero generare discriminazioni – quelli che gestiscono l’ingresso dei migranti nell’Unione o i giudici robot, che nell’amministrazione della giustizia decidono su fatti concreti.

Infine, tutte le attività che elaborano dati biologici degli individui (biometria) sono da considerarsi ad alto rischio. Tra questi, informazioni sul dna, su cartelle cliniche etc… Le Ia biometriche non potranno essere utilizzate nel “law enforcement”, salvo casi gravissimi come rapimenti o lotta al terrorismo.

- Effettuare un’analisi dei rischi adeguata e chiare strategie di minimizzazione.

- Garantire che i dataset siano di alta qualità, sempre per ridurre i margini d’errore.

- Stilare una cronologia delle attività della macchina, per rendere i risultati tracciabili.

- Fornire tutte le documentazioni necessarie alle autorità per valutare la conformità del software al suo scopo.

- Fornire all’utente informazioni chiare e adeguate sull’Ia (principio di trasparenza).

- Applicare una supervisione umana adeguata, in modo da minimizzare i rischi.

- Garantire un alto livello di robustezza, sicurezza e precisione.

Il punto 3 può risultare problematico per quelle Ia così sofisticate da essere in grado di creare da sole i propri algoritmi.

Nel punto 6, l’Ue ribadisce il principio per cui la supervisione umana è la vera garanzia di sicurezza.